安装Ollama

打开 Ollama官网 https://ollama.com/下载安装

部署DeepSeek R1模型

下载模型,自行选择1.5b、7b、8b、14b、32b、671b在终端输入:

ollama pull deepseek-r1:1.5b运行模型

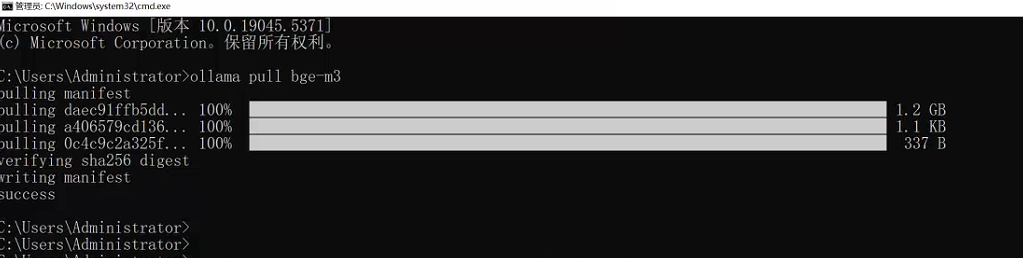

ollama run deepseek-r1:1.5b下载嵌入模型,嵌入模型也有很多个自行选择

ollama pull bge-m3

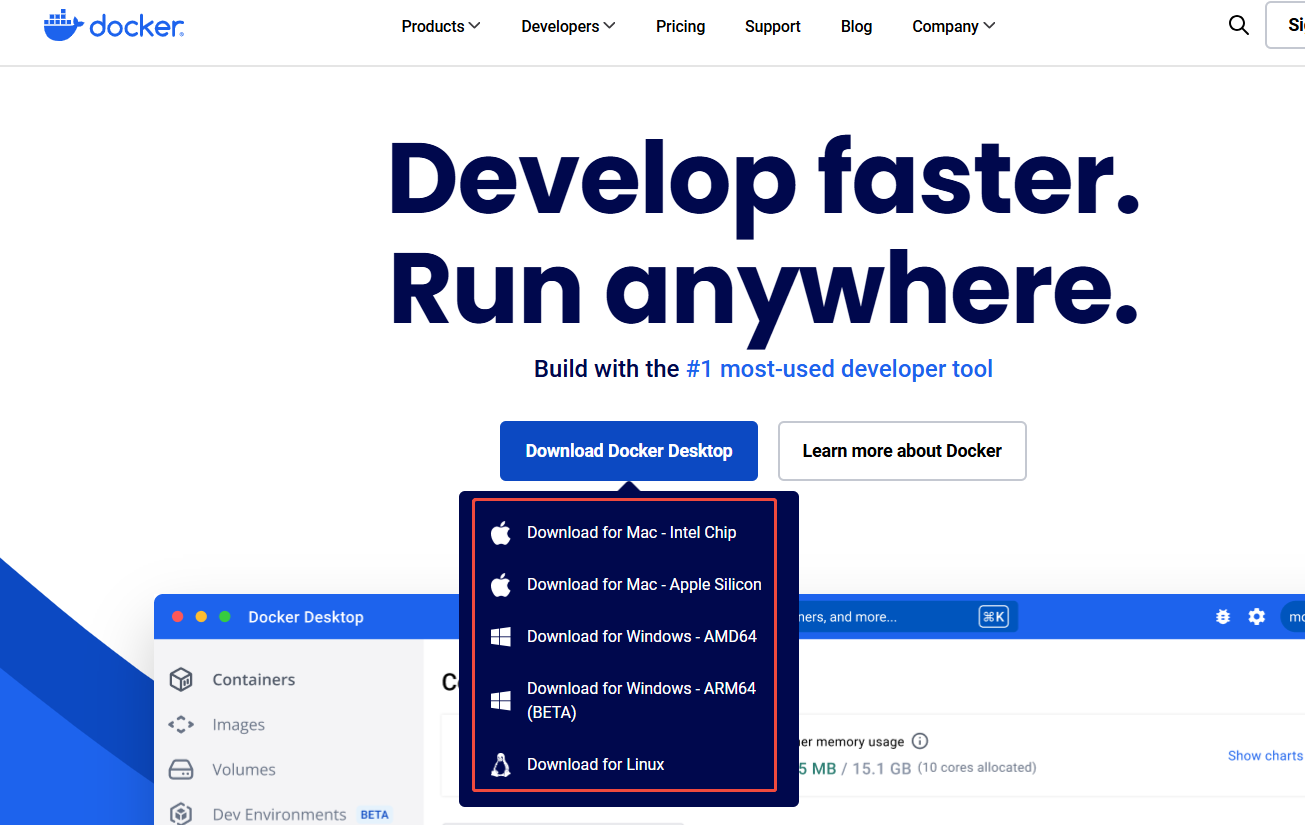

安装Docker

选择匹配自己机器的版本下载安装 https://www.docker.com/

安装之前确认设备虚拟化已启用

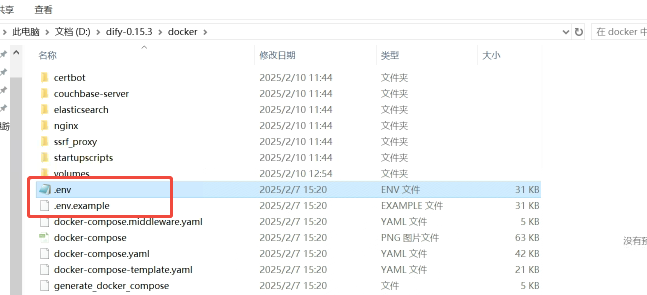

安装Dify

GitHub地址:https://github.com/langgenius/dify

将dify开源项目直接下载并解压到本地,将.env.example文件复制一份命名为.env

复制解压的位置路径

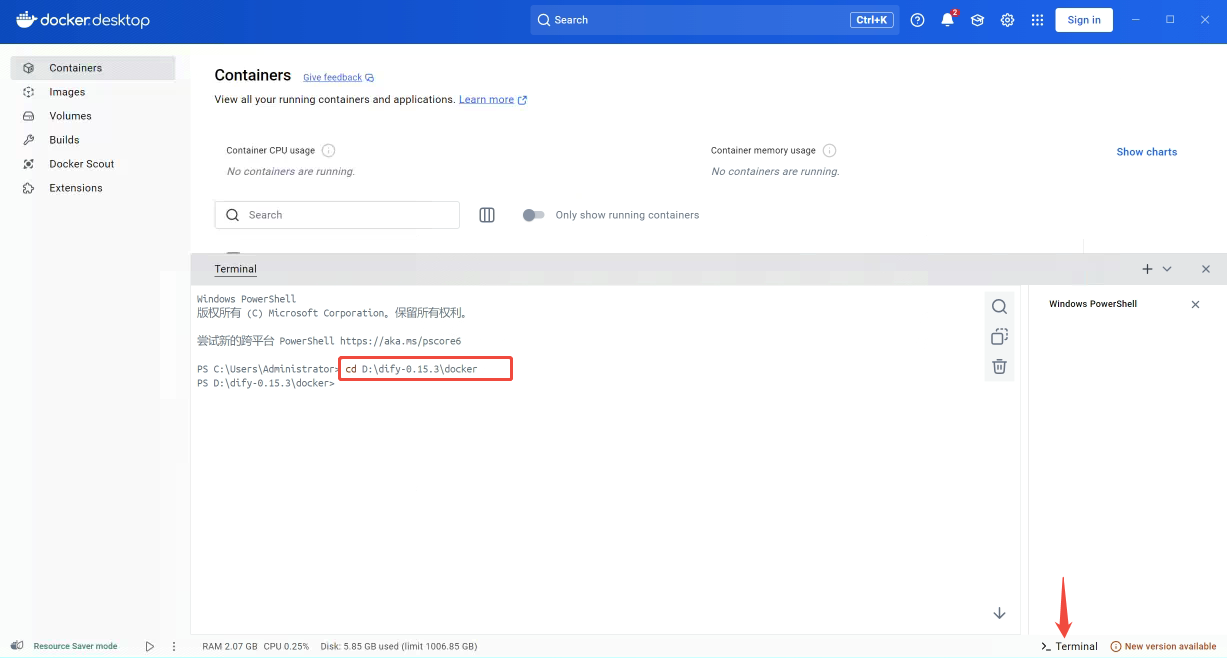

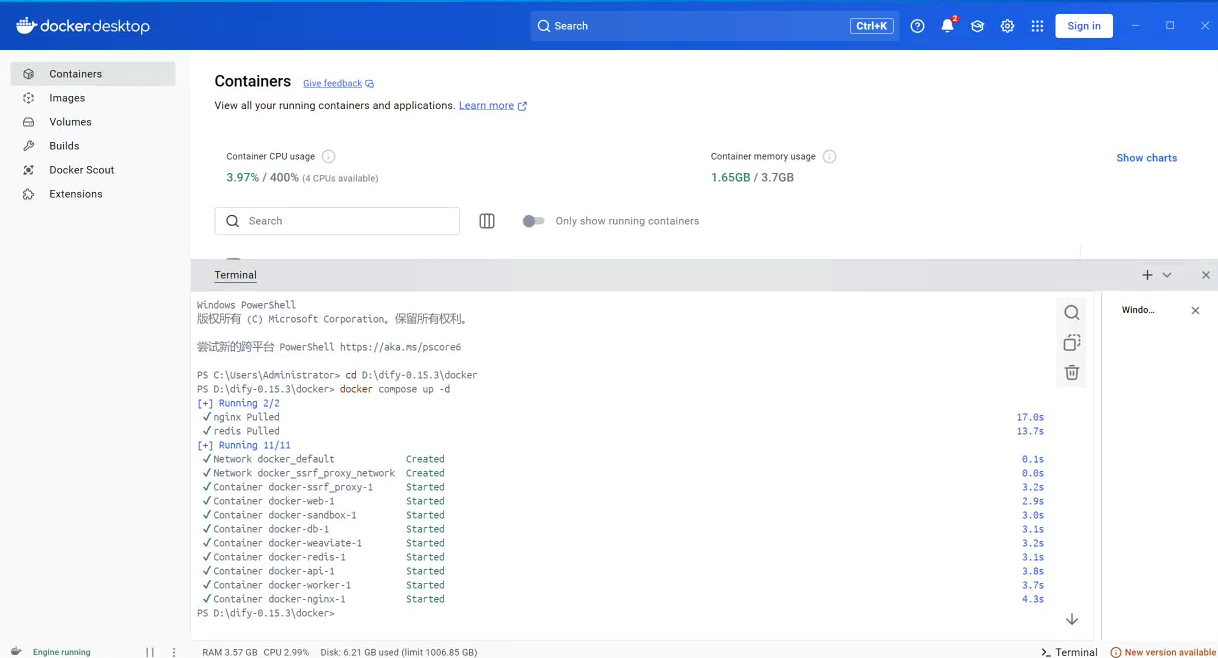

打开Dockerdesktop,点开终端,切换到目录位置

cd D:\dify-0.15.3\docker

通过docker compose启动Dify相关容器

docker compose up -d

配置Dify

我这里的192.168.11.51是局域网部署docker的IP。

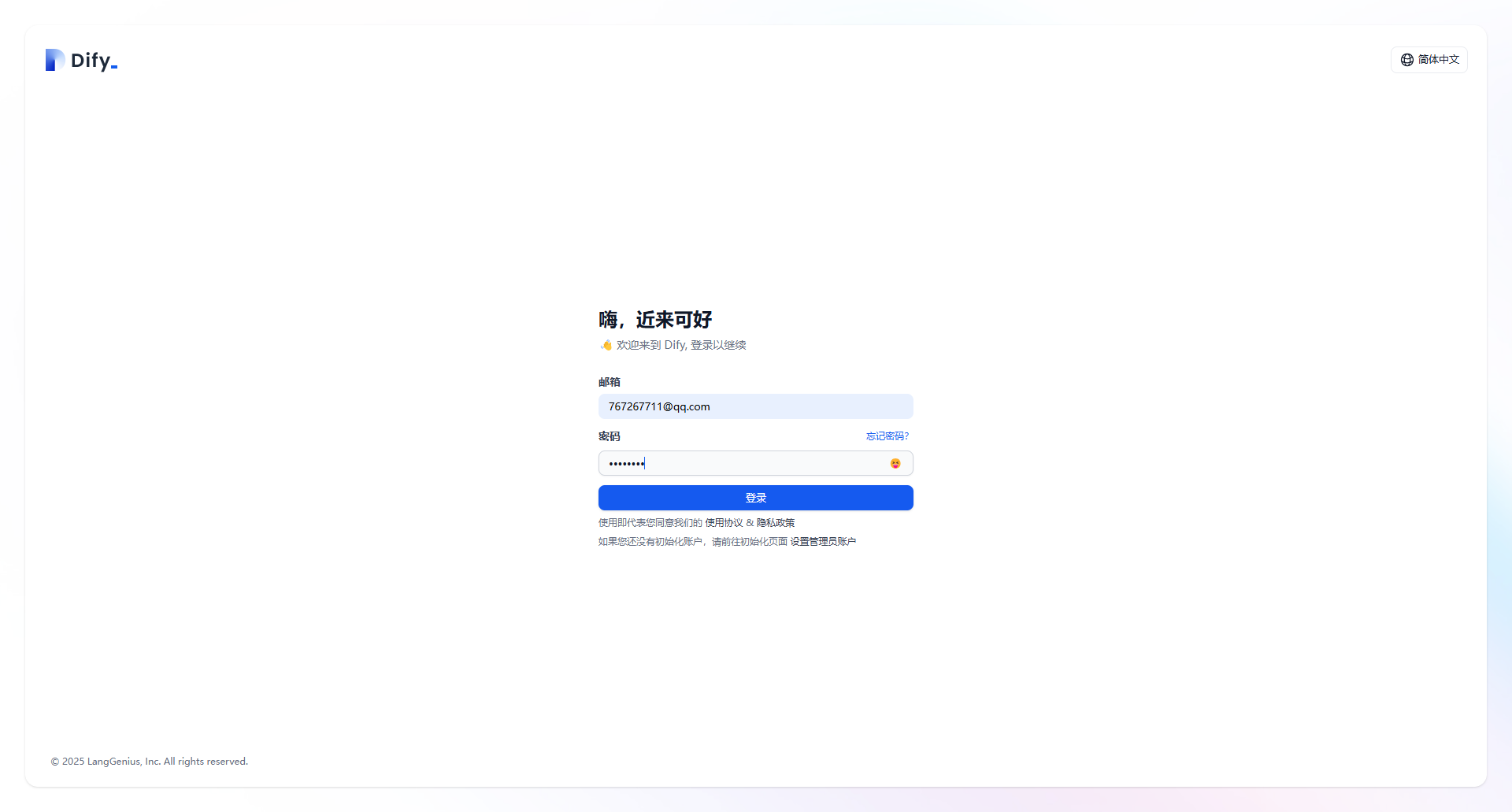

首次访问配置dify地址:http://192.168.11.51/install

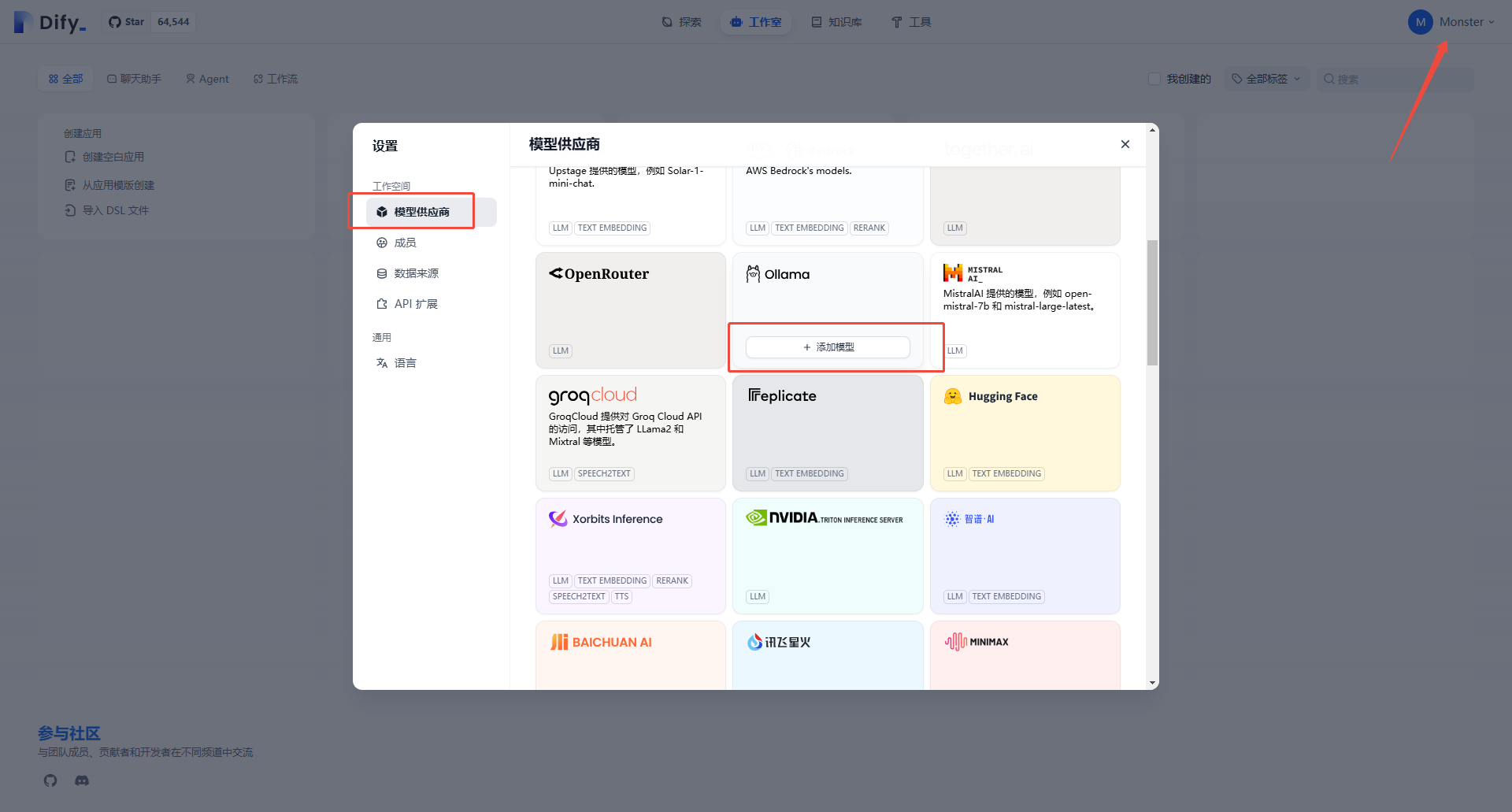

登录Dify后,点击右上角头像选择设置,添加模型供应商

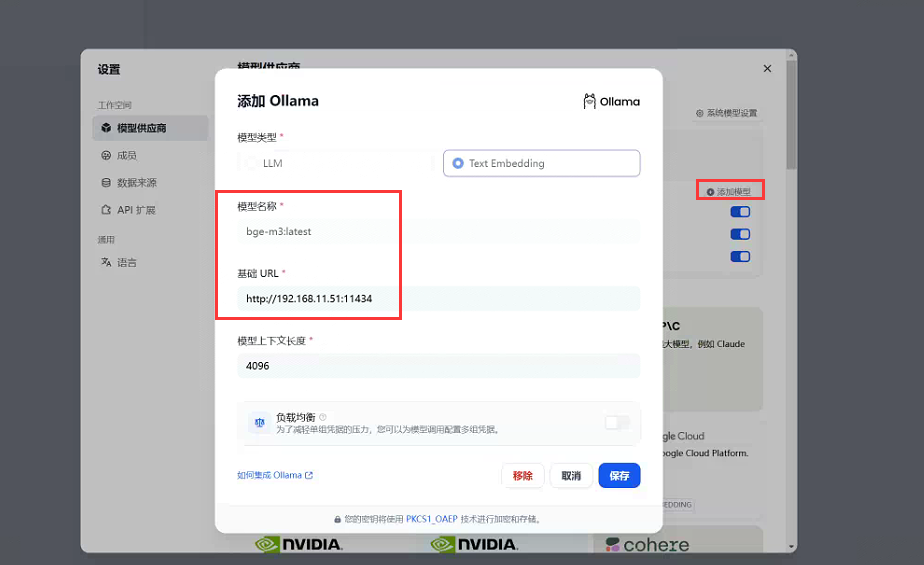

填写DeepSeek模型名称和Ollama地址

注意:模型名称需要一致,不能自定义

继续添加嵌入模型,选择Text Embedding,同样模型名称需要一致

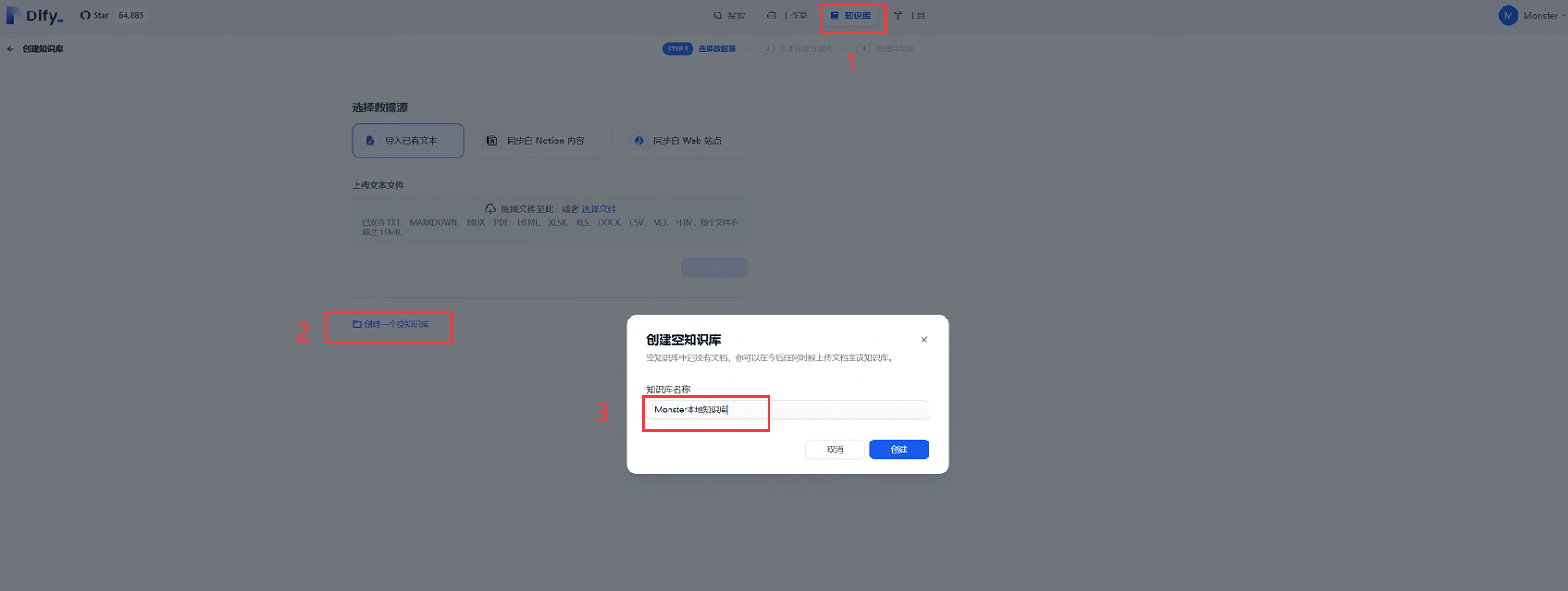

配置本地知识库

先创建个空的知识库

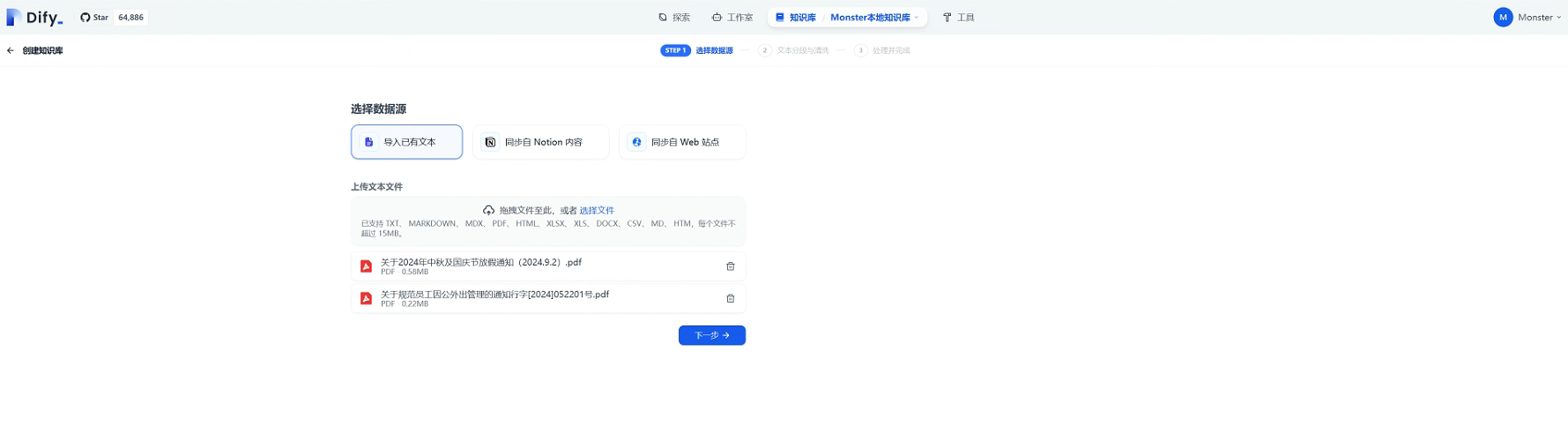

然后添加文档上传

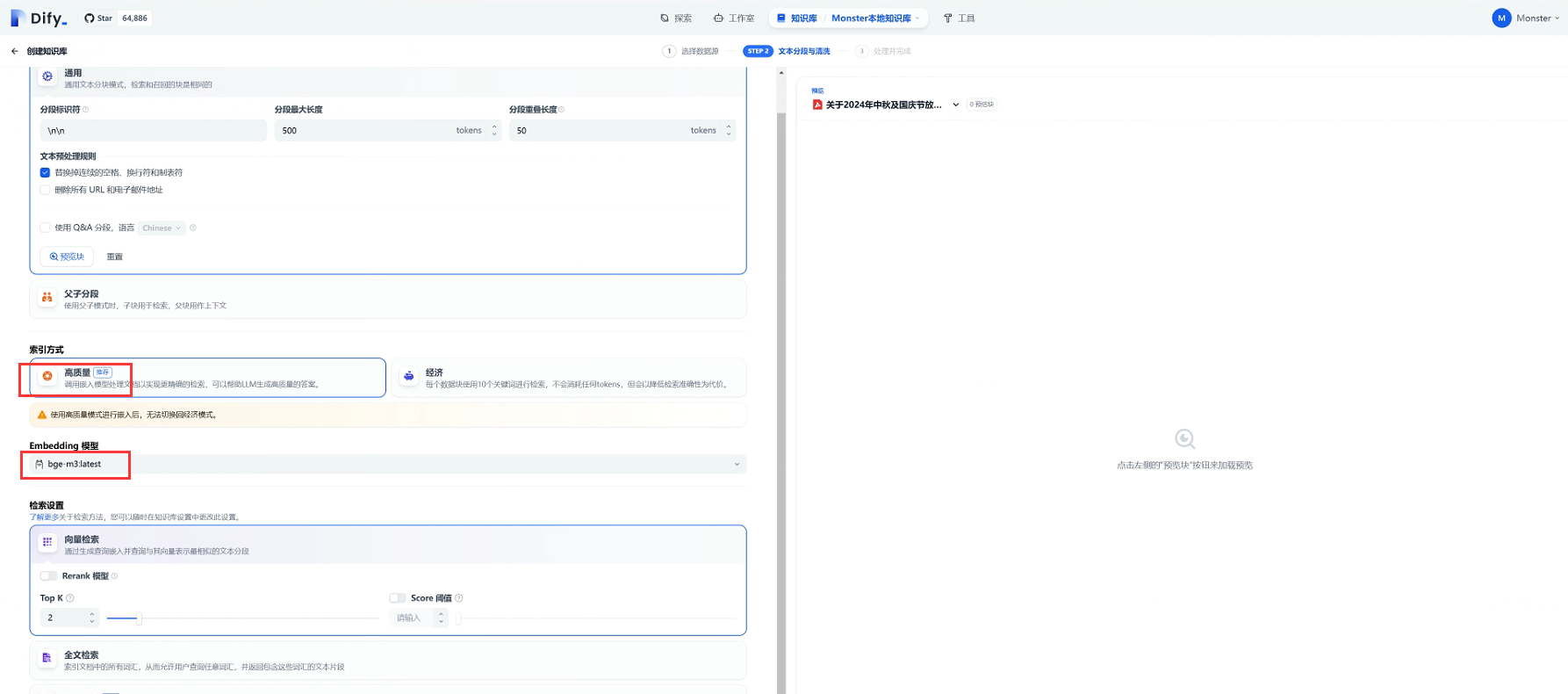

绑定我们前面下载的嵌入模型,不下嵌入模型不支持高质量选择。

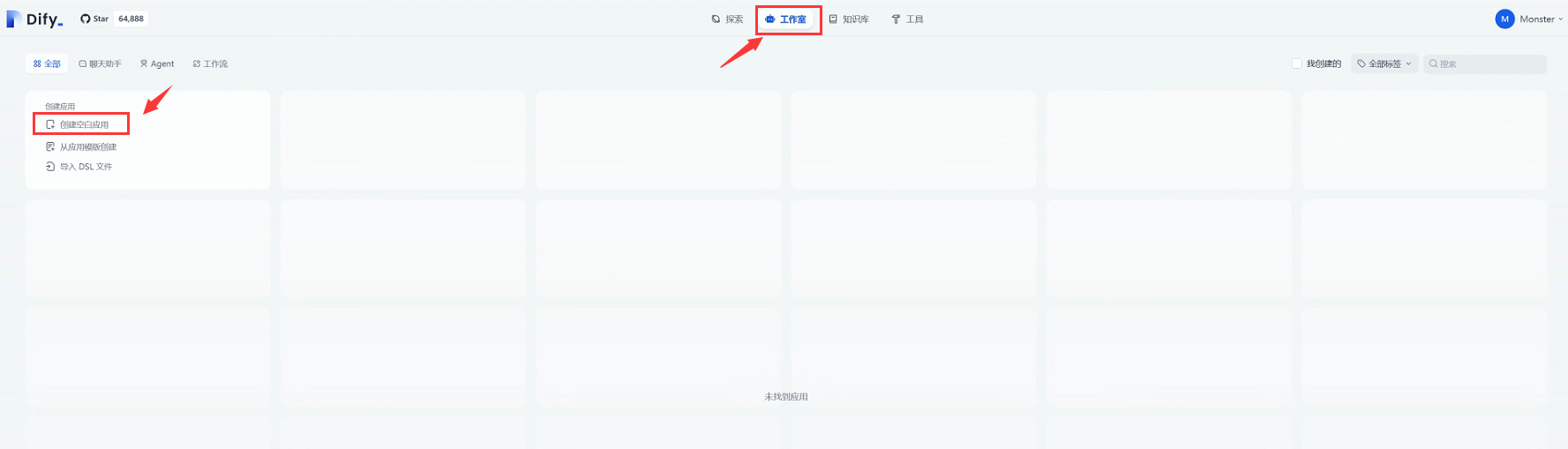

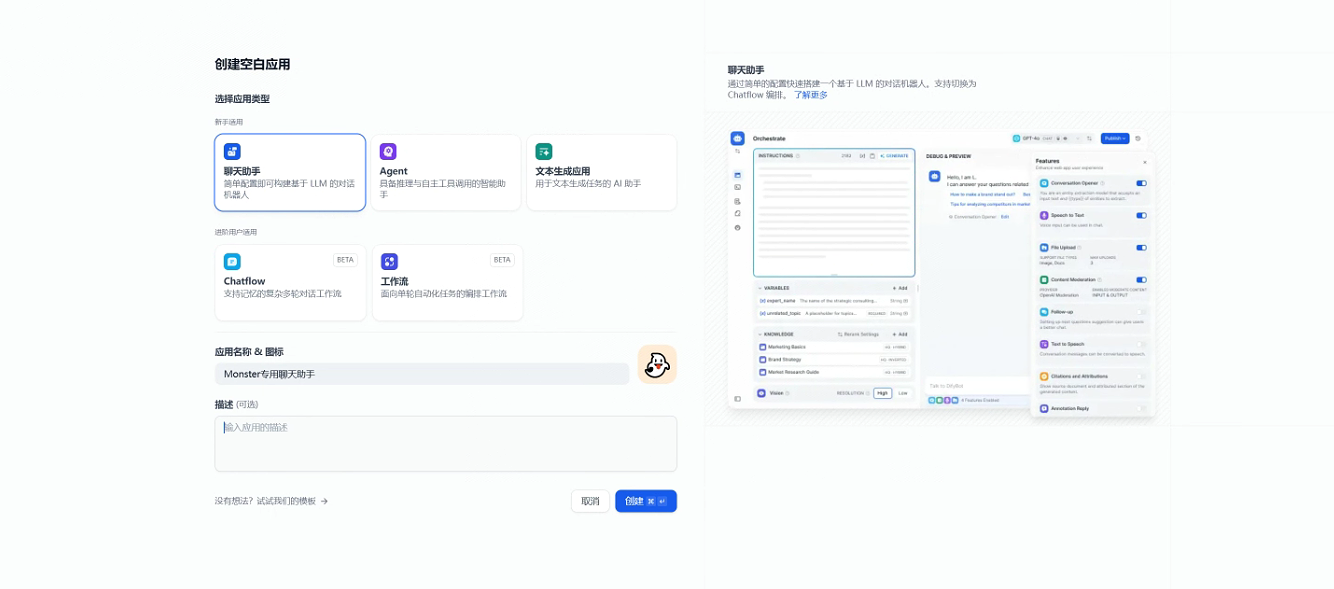

配置聊天助手

点击工作室-创建空白应用

选择聊天助手

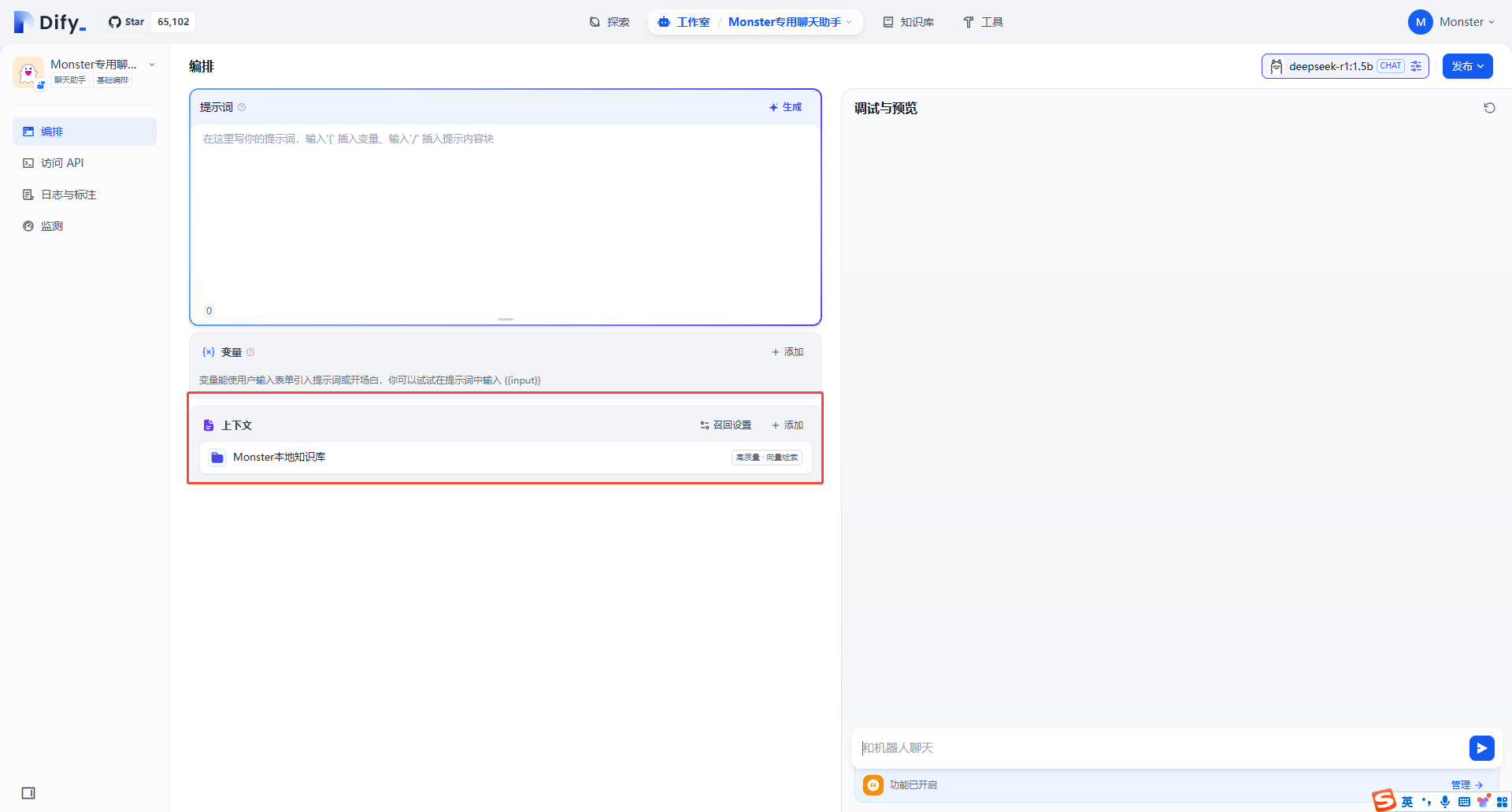

上下文绑定我们的知识库

上下文绑定我们的知识库

试看效果,优先匹配本地知识库

评论区