安装Ollama

打开 Ollama官网 https://ollama.com/下载安装

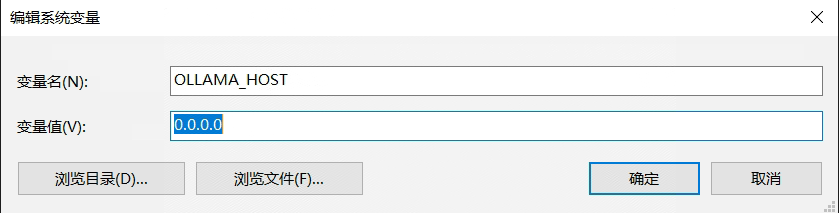

Ollama服务默认只允许本机访问,修改允许其它主机访问

Ollama服务默认只允许本机访问,修改允许其它主机访问

OLLAMA_HOST=0.0.0.0 ollama serve也可以添加系统环境变量

都知道模型体积很大,顺便也通过环境变量修改模型存放位置,我这里修改到D盘下

部署DeepSeek R1模型

下载模型,自行选择1.5b、7b、8b、14b、32b、671b在终端输入:

ollama pull deepseek-r1:14b运行模型

ollama run deepseek-r1:14b安装Docker

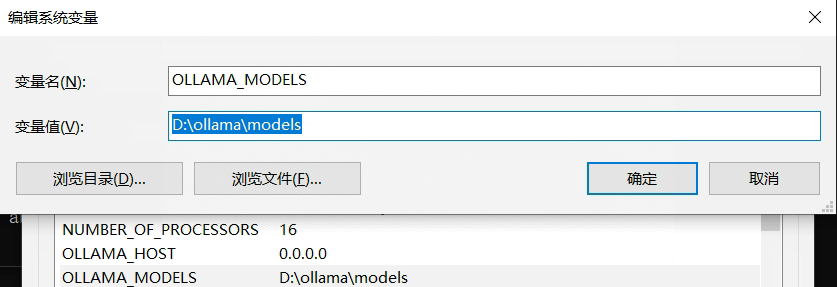

选择匹配自己机器的版本下载安装 https://www.docker.com/

安装之前确认设备虚拟化已启用

安装Open WebUI

Open WebUI的前身就叫Ollama WebUI,所以它们的兼容性毋庸置疑。

如果Ollama在您的计算机上,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main如果Ollama位于其他服务器上,请使用以下命令:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main要运行支持Nvidia GPU的Open WebUI,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda通过IP:端口号访问OpenWebUI,默认端口号3000可以自行修改,开始使用

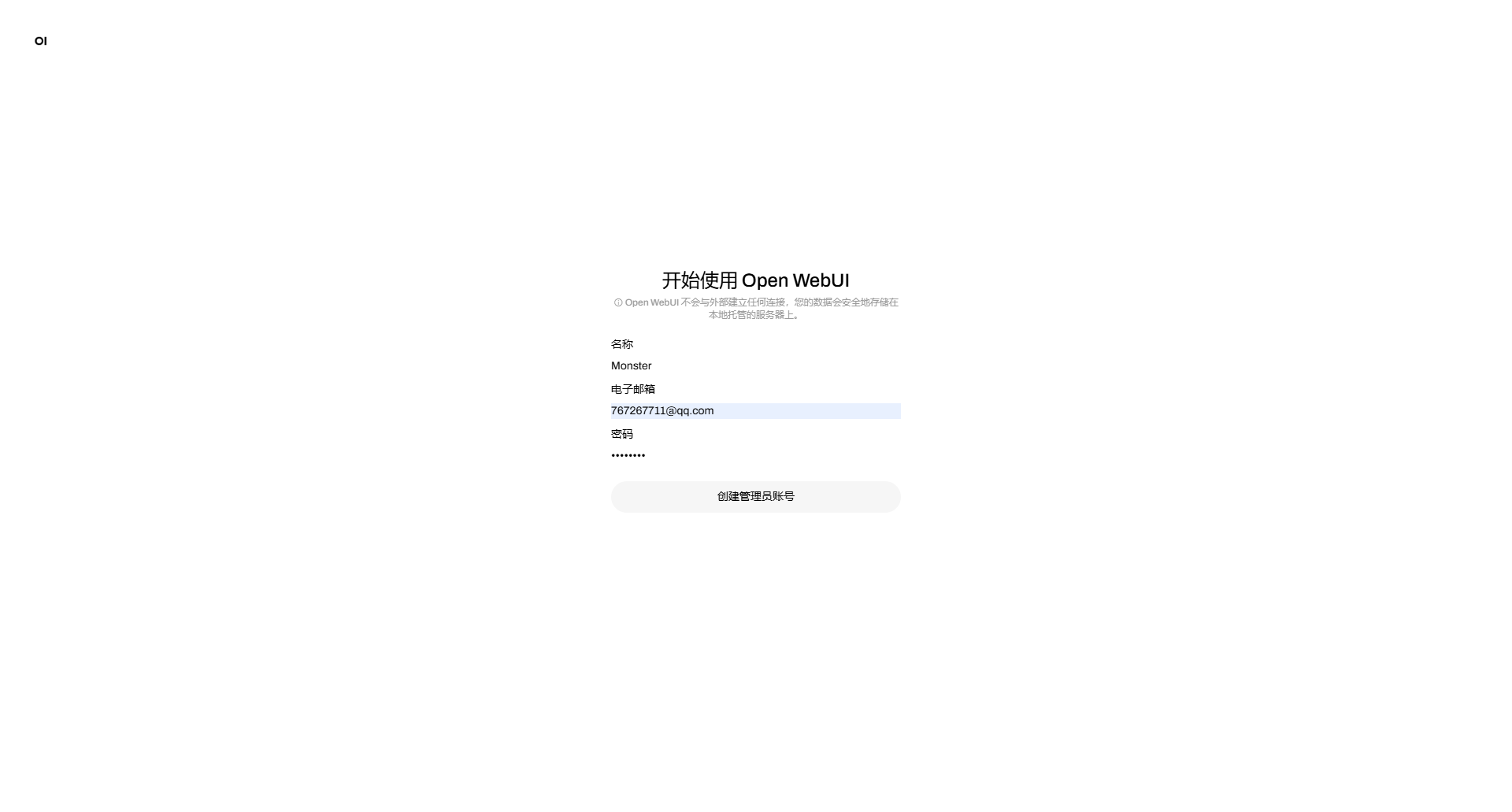

首次登录创建管理员账户

进来,点击确认开始使用

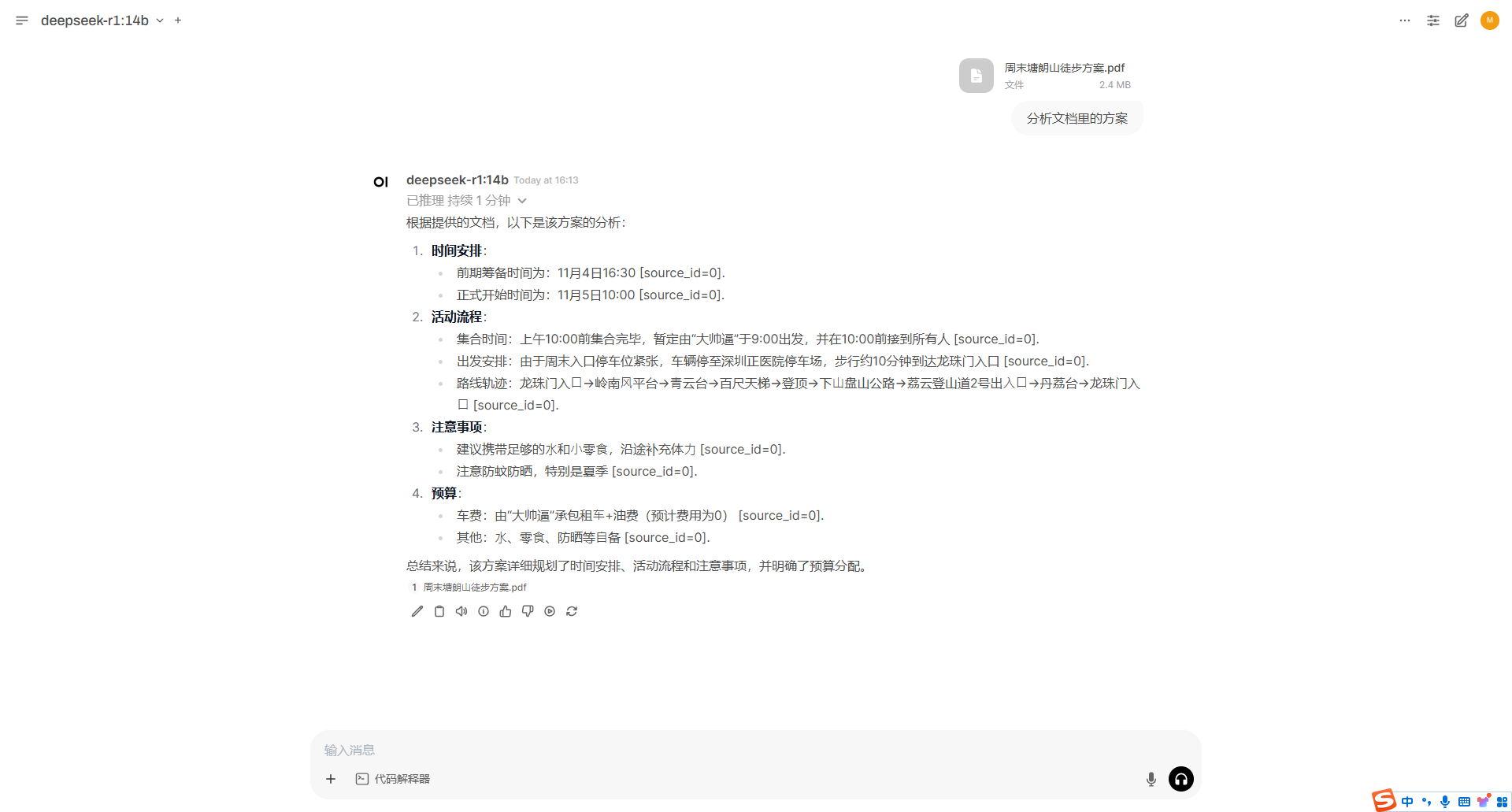

左上角切换模型

可以直接使用了,直接原生态就支持文件、图片、语音,还可以语音播报和用户控制等等,总的来说OpenWebUI是值得推荐的。

可以直接使用了,直接原生态就支持文件、图片、语音,还可以语音播报和用户控制等等,总的来说OpenWebUI是值得推荐的。

创建知识库

点击工作空间-知识库-新建一个知识库,命令介绍,可见性是公开还是私密

在右上角添加文档或目录包括直接新建文本。

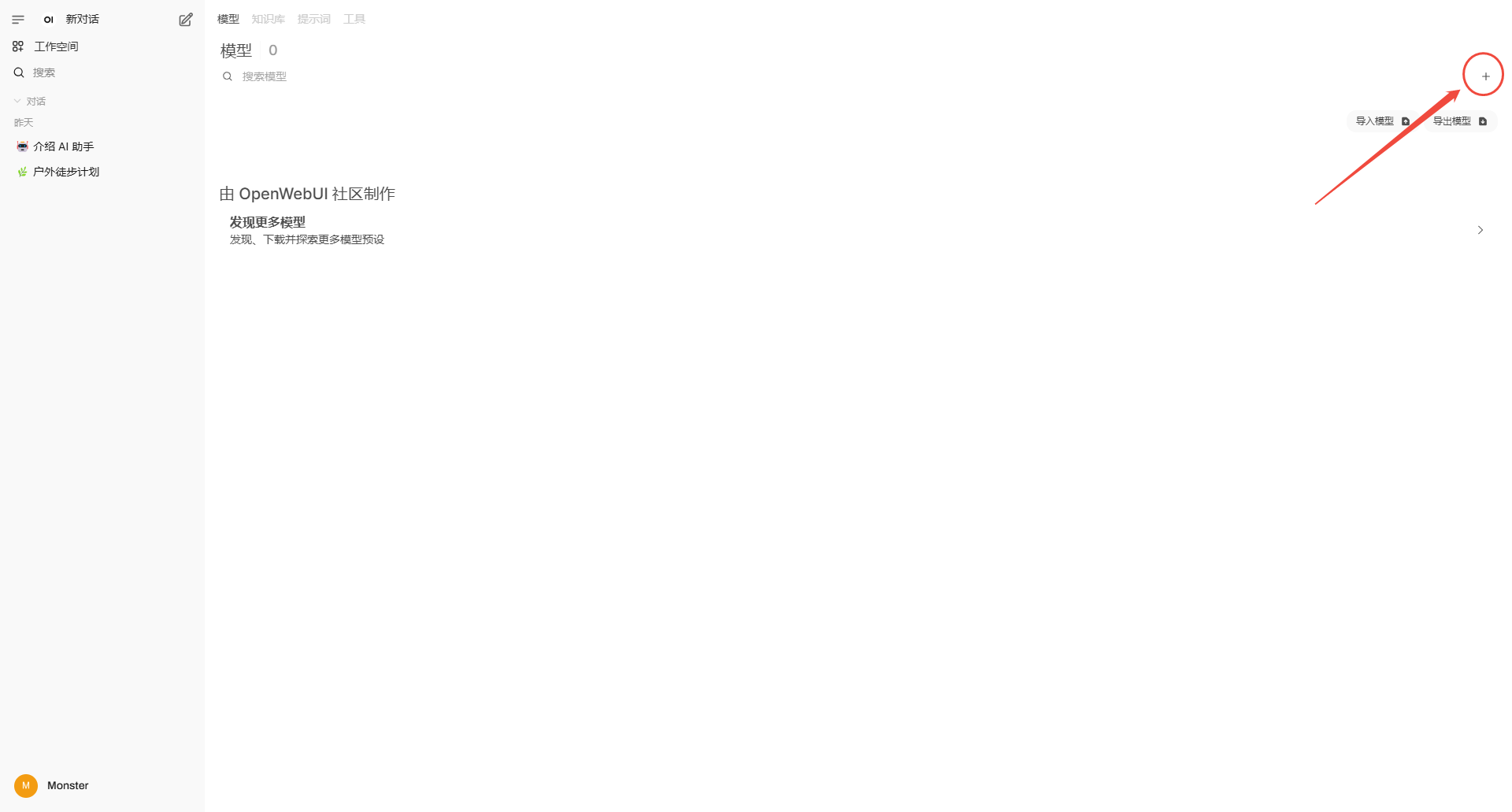

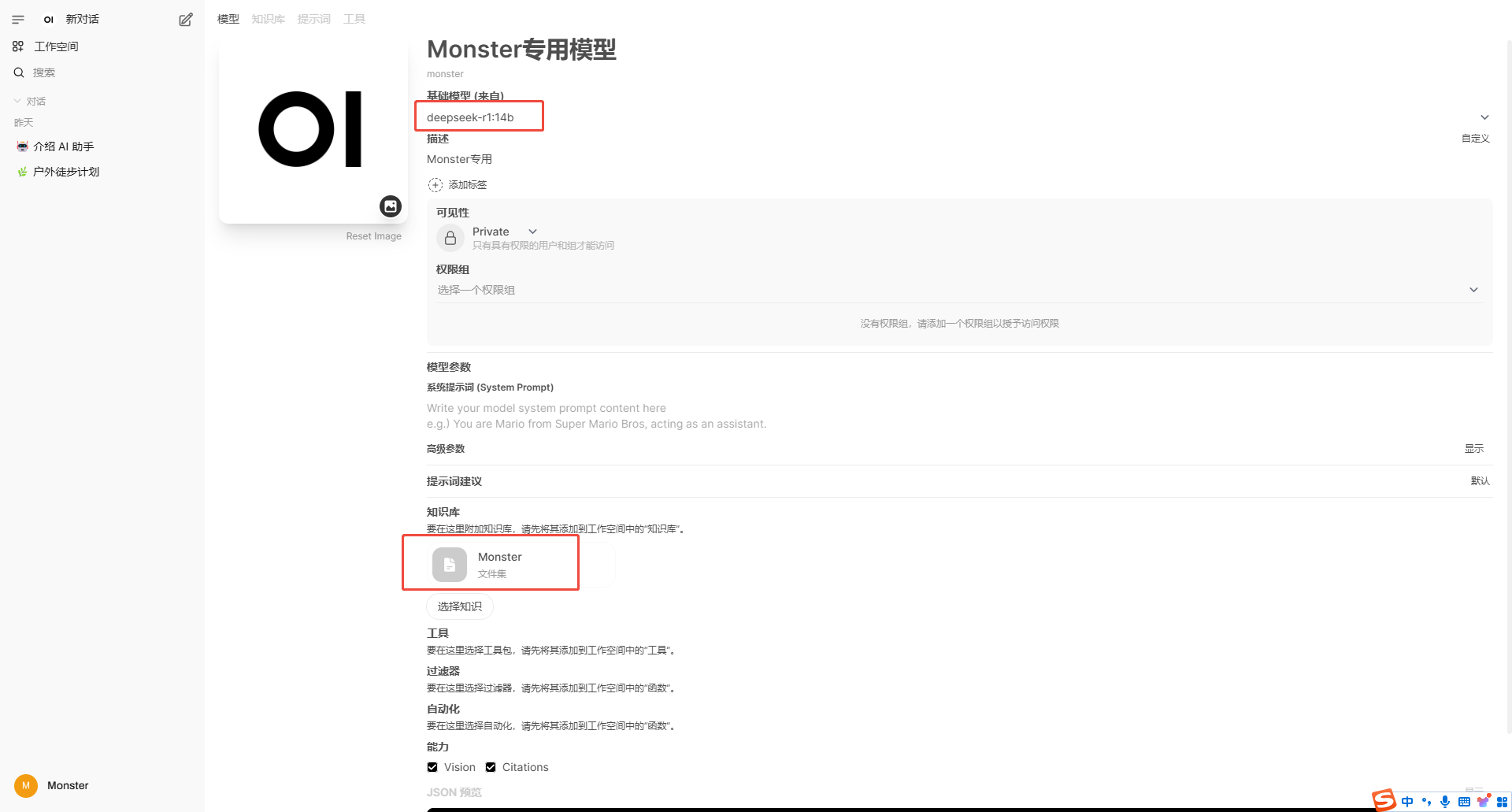

创建模型

知识库建立号,上传文档后,需要新建个模型绑定我们的知识库

填充创建信息,选择DeepSeek和知识库

新建一个对话,选择我们刚才绑定知识库创建的模型

评论区